« Les solutions d’IA permettent de réduire considérablement le travail manuel dans la sécurité des applications, la gestion des vulnérabilités et les opérations de sécurité. Malgré certains progrès dans l’automatisation des flux de travail, les équipes de sécurité sont, aujourd’hui encore, submergées par le volume qu’elles doivent traiter. L’enquête révèle que les leaders de la sécurité tirent parti de cette nouvelle technologie pour anticiper ce problème et détecter et remédier rapidement aux risques de sécurité. L’astuce consiste désormais à réduire le taux de faux positifs pour les signaux de sécurité pilotés par l’IA et à intégrer efficacement ces solutions dans les flux de travail afin qu’elles soient mises à profit. » - Marshall Irwin, CISO, Fastly

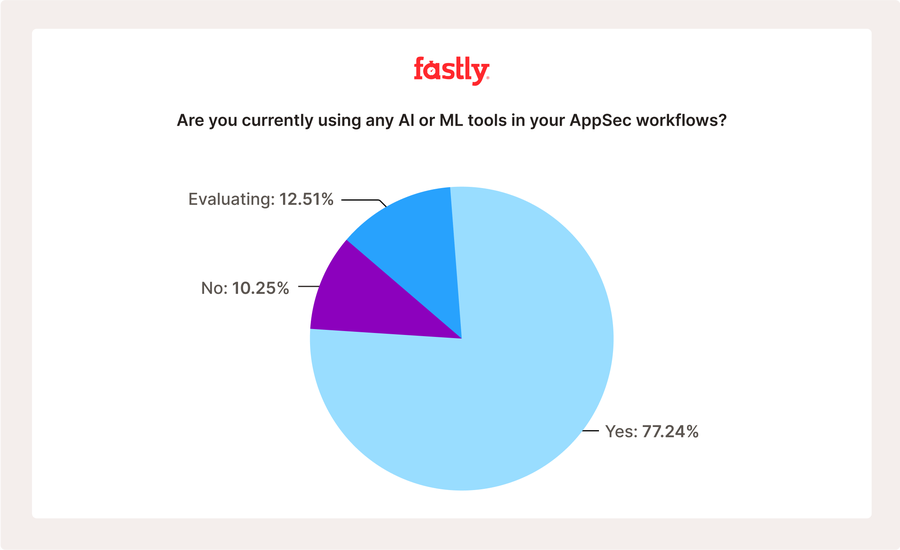

L’intégration rapide de l’intelligence artificielle (IA) dans la sécurité des applications (AppSec) a été saluée comme un changement transformateur, promettant d’alléger les efforts manuels écrasants et d’accélérer la détection des vulnérabilités. Avec des surfaces d’attaque en expansion, des ressources limitées et la pression pour livrer plus de code rapidement (mais toujours en toute sécurité), nous avons émis l’hypothèse que l’IA pourrait aider à combler cette lacune. En effet, notre dernière enquête révèle une tendance frappante : 90 % des personnes interrogées exploitent déjà l’IA ou l’envisagent activement dans le cadre de leurs programmes AppSec ; répartis dans toutes les régions et tous les secteurs d’activité, 77 % des personnes interrogées utilisent déjà l’IA et 13 % évaluent l’IA au moins dans une certaine mesure dans le cadre de leurs programmes et flux de travail AppSec.

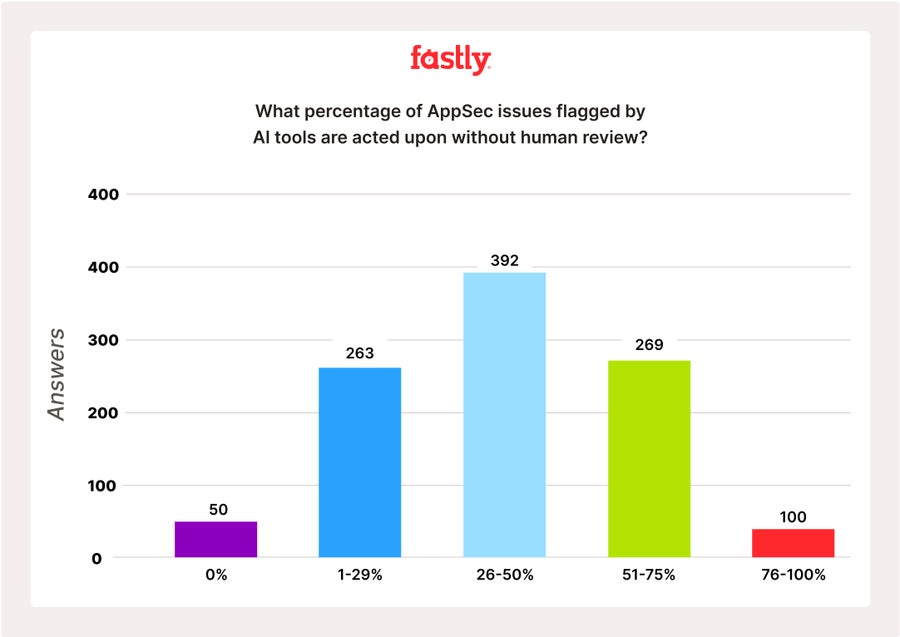

Pourtant, derrière cette adoption motivée se cache un paradoxe critique et inquiétant : malgré cette forte dépendance à l’IA, les personnes interrogées soulignent un manque, voire une absence, de supervision des résultats de l’IA. Un tiers des personnes interrogées ont déclaré que 50 % ou plus des problèmes AppSec identifiés par l’outil d’IA dans leurs flux de travail sont traités sans examen humain. S’agit-il donc d’un indicateur de confiance ou d’un symptôme indiquant que les équipes prennent des risques calculés pour suivre le rythme ?

Tendances d’adoption de l’IA : une analyse approfondie mondiale et sectorielle

77 % des personnes interrogées ont déclaré utiliser déjà l’IA dans leurs flux de travail AppSec existants, le secteur de la haute technologie arrivant en tête (88 % utilisent l’IA dans les cas d’utilisation d’AppSec). Les secteurs du SaaS (86 %) et de la santé (82 %) suivent de près, tandis que celui des médias et du divertissement (73 %) et le secteur public (64 %) sont légèrement en retard dans l’adoption de l’IA. L’Amérique du Sud a connu la plus forte dépendance à l’IA en atteignant les 90 %, suivie de l’Asie (82 %) et de l’Europe (80 %). L’Amérique du Nord a enregistré un peu de retard avec 75 %. Tous ces résultats semblent indiquer des différences potentielles en matière de ressources ou de talents, l’Amérique du Nord s’appuyant moins sur l’IA, peut-être en raison d’un réservoir de talents saturé dans le domaine de la sécurité et de la technologie ?

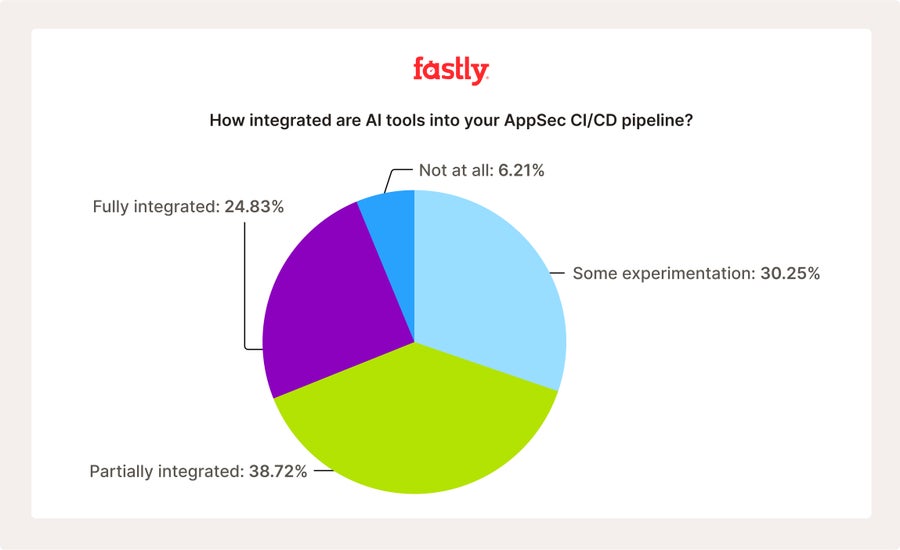

Lorsqu’on leur a demandé plus d’informations sur l’intégration dans les pipelines CI/CD existants et dans quelle mesure les outils de sécurité basés sur l’IA sont en place, 25 % des répondants ont indiqué que l’IA était entièrement intégrée dans leurs pipelines de développement existants. 39 % ont déclaré que l’IA était partiellement intégrée, 31 % qu’ils « expérimentaient » la mise en œuvre, et seulement 6 % qu’elle n’était « pas du tout intégrée » dans les flux de travail existants à l’heure actuelle. Les mêmes tendances régionales révélées par la question précédente se retrouvent ici aussi : 38 % des répondants d’Amérique du Sud ont déclaré que l’IA était pleinement intégrée dans leurs pipelines existants, contre seulement 25 % en Amérique du Nord. Par secteur d’activité, celui de la haute technologie a enregistré l’intégration la plus complète (40 %) par rapport au secteur des médias et du divertissement (19 % entièrement intégrée) et des jeux vidéo (15 % entièrement intégrée).

Les avantages de l’IA pour les répondants sont clairs : 55 % font état d’une réduction (évidente) des efforts manuels, 50 % d’une « détection plus rapide des vulnérabilités », 36 % d’une réduction plus rapide des délais de correction des vulnérabilités et 43 % ont noté de meilleures capacités de triage. Mais ces avantages se font-ils au détriment de la précision et de la véritable sécurité ?

Confiance et précision : évaluation de la fiabilité de l'IA dans l'AppSec

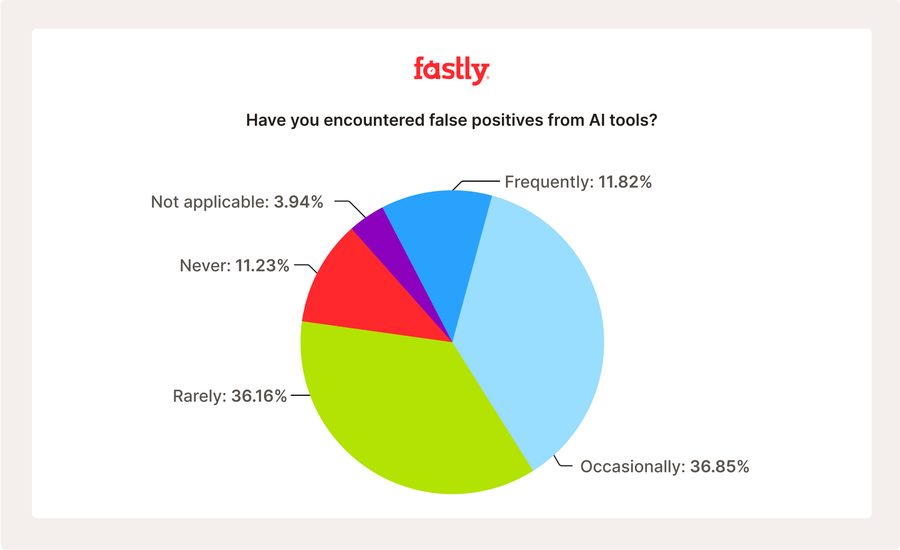

Compte tenu des chiffres élevés d’adoption et d’intégration, nous avons voulu mieux comprendre le ressenti des personnes interrogées quant à la fiabilité et à la confiance envers l’IA. Nous avons interrogé ces personnes sur la prévalence des faux positifs liés aux outils de sécurité pilotés par l’IA. 37 % ont fait état de faux positifs occasionnels et 12 % ont signalé des faux positifs plus fréquents, soit un total de près de la moitié (49 %) des personnes interrogées qui obtiennent fréquemment des faux positifs. Cette constatation pourrait avoir un impact négatif significatif sur n’importe quel programme de sécurité. Seulement 11 % ont déclaré ne jamais obtenir de faux positifs. Il s’agit donc de savoir si les outils de sécurité pilotés par l’IA donnent vraiment des résultats de sécurité « suffisants ».

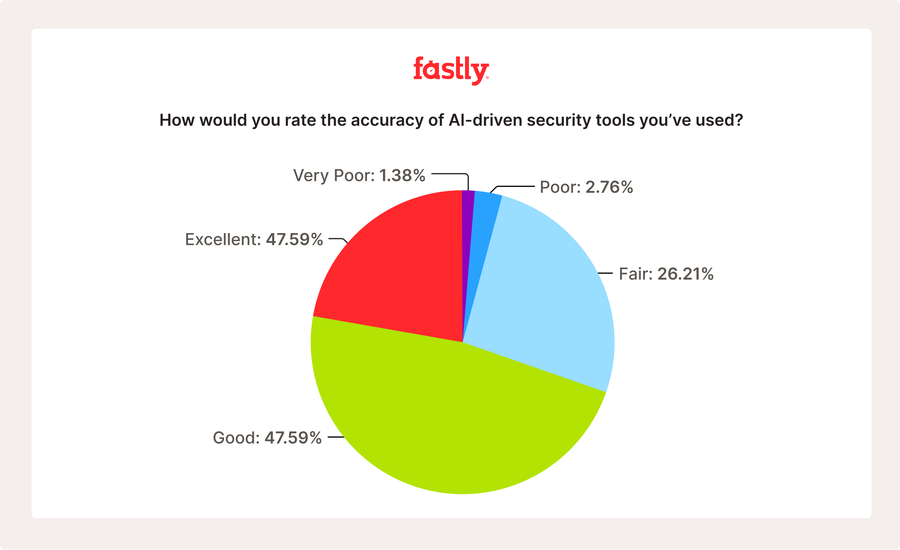

Nous avons approfondi nos recherches, remettant en question la confiance générale dans la précision de l’IA. Seulement 22 % des personnes interrogées l’ont qualifiée d’« excellente », 48 % l’ont qualifiée de « suffisante » et, au total, 30 % l’ont qualifiée de « passable » ou de « très mauvaise ». Nous avons voulu nous intéresser plus en détail aux défis rencontrés par les équipes de sécurité lors de l’utilisation de l’IA dans leurs flux de travail de sécurité. Pouvant sélectionner diverses réponses, les répondants ont indiqué que la « complexité de l’intégration » (46 %), le manque de confiance dans les résultats (36 %), la mauvaise explication des conclusions en matière de sécurité (23 %), les lacunes en matière de compétences internes (38 %) et les préoccupations réglementaires ou de conformité (33 %) font hésiter les équipes de sécurité.

Dans leurs réponses libres, les personnes interrogées ont indiqué qu’elles « doivent effectuer trop de corrections » et qu’elles « ont des préoccupations éthiques et de conformité » concernant l’utilisation de l’IA dans leurs flux de travail de sécurité.

Une lacune critique : les problèmes liés à la sécurité des applications ont été résolus sans intervention humaine

Une tendance claire se dégage des chiffres liés à l’adoption et à l’intégration avec les réponses des répondants concernant la supervision, la confiance et les résultats liés à l’IA : l’IA est intégrée, elle permet une accélération et comble le manque de ressources et de compétences… mais elle n’est pas parfaite. Face aux faux positifs et aux opinions divergentes quant à sa fiabilité et à sa précision globale, nous souhaitions comprendre quelles mesures de protection, le cas échéant, les organisations ont mises en place pour vérifier les résultats de sécurité.

Nous avons demandé aux personnes interrogées quel pourcentage des erreurs détectées à l’aide d’outils de sécurité pilotés par l’IA était traité SANS intervention humaine. 4 % des répondants ont déclaré qu’entre 76 et 100 % des erreurs identifiées sont traitées sans intervention humaine. 26 % des répondants ont déclaré que 51 à 75 % des erreurs identifiées sont traitées sans intervention humaine. Par ailleurs, 26 % des personnes interrogées ont déclaré qu’entre 1 et 25 % des erreurs identifiées sont traitées sans intervention humaine.

De même, un tiers des personnes interrogées déclare que 50 % ou plus des problèmes AppSec identifiés par les outils pilotés par l’IA dans les flux de travail sont traités sans aucune intervention humaine. Compte tenu des opinions mitigées sur la précision et les performances globales de l’IA, on suppose que le manque de supervision tient d’un mélange de ressources et de bande passante limitées, associé à des tolérances au risque suffisamment élevées pour accepter que l’IA soit « suffisante ».

Nous avons demandé aux organisations qui appliquent un certain niveau de supervision de l’IA quelles mesures de contrôle de la gouvernance elles ont mises en place pour vérifier les résultats. Avec plusieurs réponses possibles, 66 % ont indiqué appliquer des points de contrôle d’évaluation, 49 % utilisent la vérification des modèles d’IA, 46 % optent pour les audits et la journalisation et 32 % ont recours au sandboxing sécurisé. Bien qu’il soit prometteur de constater un tel niveau de supervision, ces valeurs doivent encore une fois être considérées en même temps que les réponses ci-dessus : bien que des pratiques de supervision décentes soient mises en place, le pourcentage de répondants qui les pratiquent est inquiétant et limité.

L’avenir de l’IA en matière d’AppSec : un potentiel pour une IA plus performante

En regardant vers l’avenir, nous avons demandé aux répondants ce qu’ils attendaient de l’IA dans les cas d’utilisation basés sur l’AppSec : 32 % ont répondu qu’ils n’étaient pas sûrs ou que l’IA faisait pour le moment un travail correct. De plus, 18 % souhaitent qu’elle soit « plus précise avec moins de faux positifs », 10 % ont indiqué un besoin de meilleures capacités spécifiques à l’AppSec en général, et 9 % souhaitent obtenir des résultats plus rapides grâce à la détection automatisée des vulnérabilités en temps réel, pendant le codage.

Parmi les points clés de cette question ouverte, un répondant « [souhaite] que l’IA soit plus transparente et qu’elle communique les détections immédiates des menaces avec une plus grande précision. » Un autre « [souhaite] que les outils d’IA puissent mieux comprendre le contexte commercial complexe afin de mieux prioriser les vulnérabilités. » Une autre personne a déclaré que « l’IA doit être capable de différencier précisément les activités légitimes des activités malveillantes tout en expliquant ses décisions. »

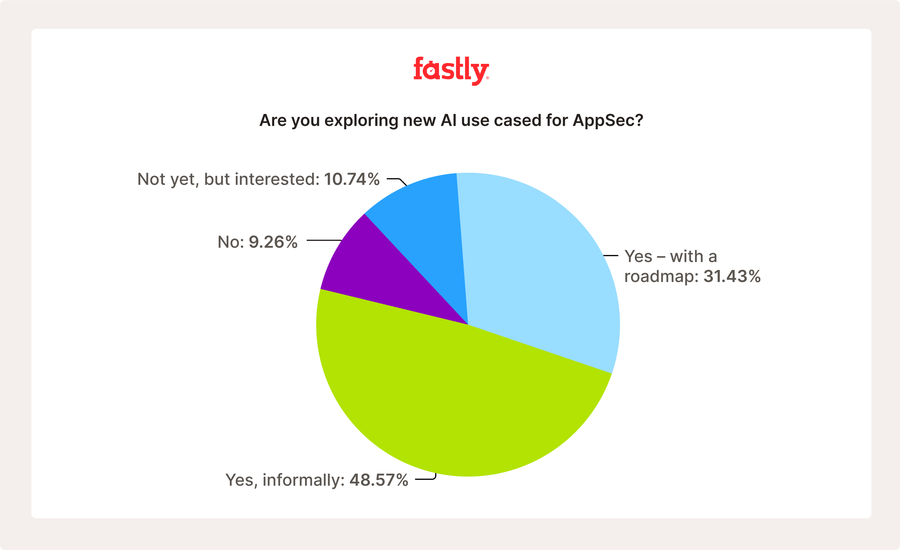

Nous avons demandé aux répondants s’ils s’intéressaient à de nouveaux cas d’utilisation de l’IA dans leurs programmes AppSec. 49 % ont déclaré que c’était le cas, bien que de manière informelle. 31 % ont répondu oui, avec une feuille de route officielle. Un total de 20 % ne s’y intéressent pas encore ou souhaitent le faire bientôt. Cela signifie que 80 % s’intéressent à de nouveaux cas d’utilisation pour l’IA. Les répondants ont déclaré « [vouloir] tester la modélisation des menaces basée sur l’IA et l’examen automatisé du code pour rendre la sécurité plus précise et efficace », et « [chercher] à faire de la remédiation automatisée, de la modélisation prédictive et de l’examen du code de l’IA ».

Méthodologie de l’enquête

Cette enquête a été menée par Fastly du 20 août au 3 septembre 2025 auprès de 1 015 professionnels. Toutes les personnes interrogées ont confirmé que, dans le cadre de leurs fonctions, elles sont chargées d’influencer ou de prendre des décisions en matière d’achat et de stratégie de sécurité des applications. L’enquête a été diffusée en Amérique du Nord, en Amérique du Sud, en Europe, au Moyen-Orient et en Asie. Les résultats ont été contrôlés pour leur précision, mais, comme pour toutes les données autodéclarées, un certain biais est possible.