„KI-Lösungen bieten die Möglichkeit, einen Großteil der manuellen Arbeit in der Anwendungssicherheit, im Schwachstellenmanagement und im Sicherheitsbetrieb zu reduzieren. Trotz einiger Fortschritte bei der Automatisierung von Workflows sind die Sicherheitsteams heute immer noch von der Menge der zu bewältigenden Aufgaben überwältigt. Die Umfrage zeigt, dass Sicherheitsverantwortliche diese neue Technologie nutzen, um dem Problem zuvorzukommen und Sicherheitsrisiken schnell zu erkennen und zu beheben. Die Herausforderung besteht nun darin, die False-Positive-Rate bei KI-gestützten Sicherheitssignalen zu senken und diese Lösungen effektiv in die Workflows zu integrieren, sodass sie nicht zu ungenutzter KI-Software werden.“ – Marshall Irwin, CISO, Fastly

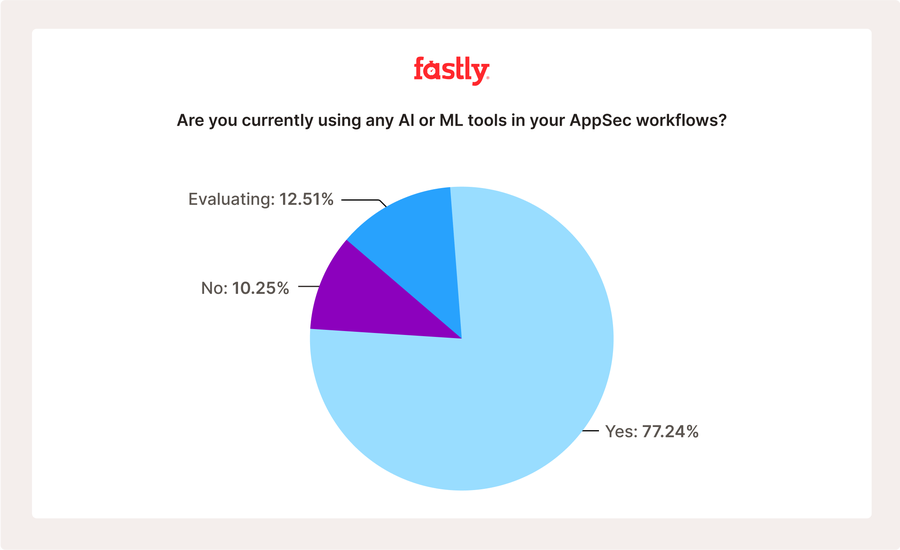

Die schnelle Integration von künstlicher Intelligenz (KI) in die Anwendungssicherheit (AppSec) wurde als bahnbrechend gefeiert und verspricht, den überwältigenden manuellen Aufwand zu verringern und die Schwachstellenerkennung zu beschleunigen. Angesichts der zunehmenden Angriffsfläche, der begrenzten Ressourcen und des Drucks, schnell (aber dennoch sicher) mehr Code auszuliefern, stellten wir die Hypothese auf, dass KI dazu beitragen könnte, diese Lücke zu schließen. In der Tat zeigt unsere jüngste Umfrage einen auffälligen Trend: erstaunliche 90 % der Befragten nutzen bereits KI oder ziehen sie aktiv für ihre AppSec-Programme in Betracht; über Regionen und Branchen hinweg nutzen bereits 77 % der Befragten KI und 13 % evaluieren KI zumindest in gewissem Umfang innerhalb ihrer AppSec-Programme und -Workflows.

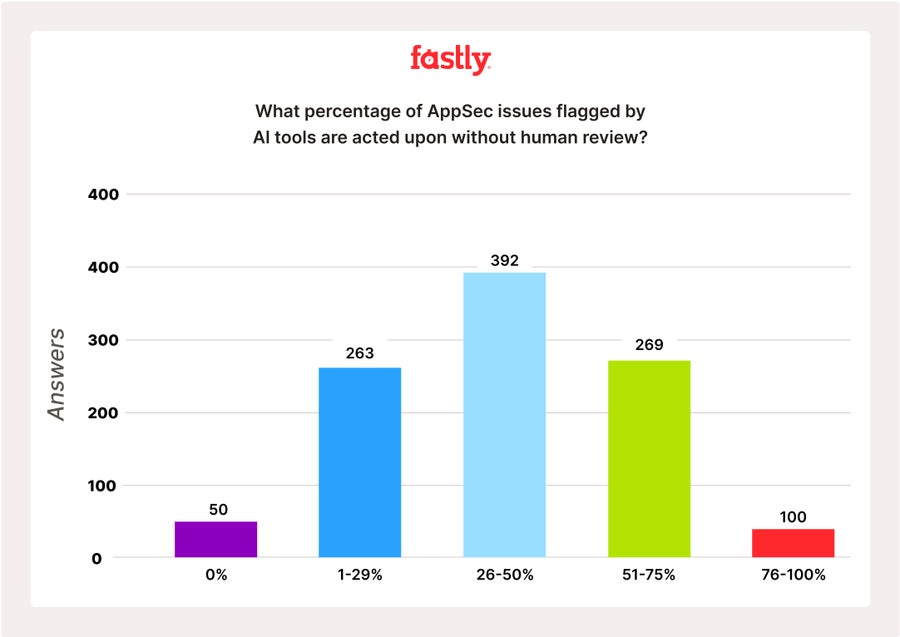

Doch hinter dieser enthusiastischen Annahme verbirgt sich ein kritisches und vielleicht besorgniserregendes Paradoxon: Trotz dieser starken Abhängigkeit von KI berichten die Befragten, dass die KI-Ergebnisse kaum oder gar nicht überwacht werden. Ein Drittel der Befragten gab an, dass 50 % oder mehr der von KI-Tools in ihren Workflows identifizierten AppSec-Probleme ohne menschliche Überprüfung behoben werden. Ist dies also ein Indikator für Vertrauen oder ein Symptom dafür, dass Teams kalkulierte Risiken eingehen, um Schritt zu halten?

Trends bei der Einführung von KI: Ein globaler und branchenspezifischer Einblick

77 % aller Befragten gaben an, bereits KI in ihren bestehenden AppSec-Workflows einzusetzen, wobei die Hightech-Branche mit 88 % den höchsten Anteil aufweist (KI wird in AppSec-Anwendungsfällen eingesetzt). SaaS (86 %) und das Gesundheitswesen (82 %) folgten dicht dahinter, während Medien und Unterhaltung (73 %) und der öffentliche Sektor (64 %) bei der KI-Einführung etwas hinterherhinkten. In Südamerika war die Inanspruchnahme von KI mit 90 % am höchsten, Asien (82 %) und Europa (80 %) lagen knapp dahinter. Nordamerika lag mit 75 % etwas zurück. Dies scheint auf mögliche Unterschiede bei den Ressourcen oder Talenten hinzuweisen, wobei Nordamerika weniger auf KI setzt – möglicherweise aufgrund eines gesättigten Pools an Sicherheits- und Techniktalenten, aus dem man schöpfen kann?

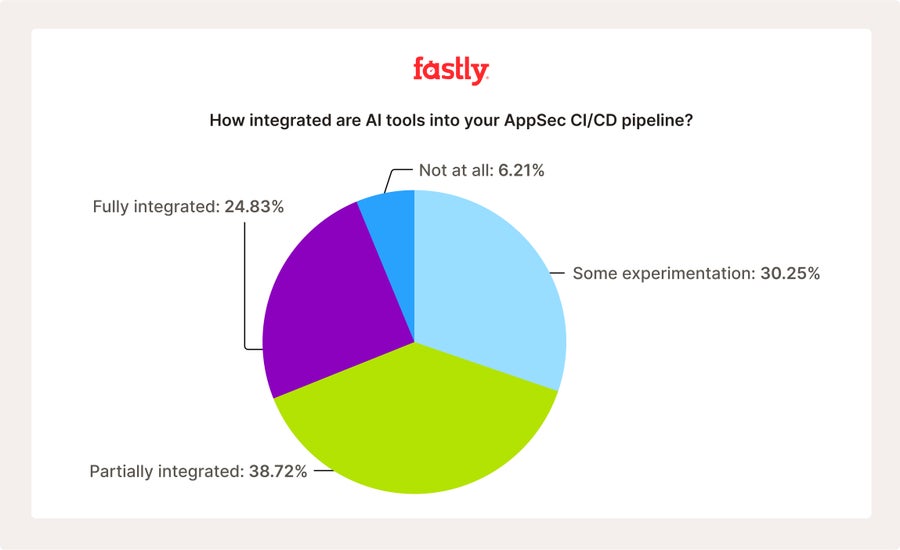

Auf die Frage nach der Integration in bestehende CI/CD-Pipelines und dem Umfang des Einsatzes von KI-gestützten Sicherheits-Tools gaben 25 % der Befragten an, dass KI vollständig in ihre bestehenden Entwicklungspipelines integriert ist. 39 % gaben an, dass sie teilweise integriert ist, 31 % gaben an, dass sie mit der Implementierung „experimentieren“, und nur 6 % gaben an, dass sie derzeit „überhaupt nicht“ in die bestehenden Workflows integriert ist. Auch hier zeigen sich die gleichen regionalen Trends wie bei der vorangegangenen Frage: 38 % der südamerikanischen Befragten gaben an, dass KI vollständig in ihre bestehenden Pipelines integriert ist. In Nordamerika waren es nur 25 %. Auf Branchenebene verzeichnete die Hightech-Branche die höchste vollständige Integration (40 %) im Vergleich zu anderen Branchen: Medien und Unterhaltung (19 % vollständig integriert), Gaming (15 % vollständig integriert).

Die Vorteile von KI für die Befragten liegen auf der Hand: 55 % berichten von einer (offensichtlichen) Reduzierung des manuellen Aufwands, 50 % berichten von einer schnelleren Erkennung von Schwachstellen, 36 % berichten von kürzeren Bearbeitungszeiten für die Behebung von Schwachstellen und 43 % stellten bessere Triage-Funktionen fest. Aber gehen diese Vorteile auf Kosten von Genauigkeit und echter Sicherheit?

Vertrauen und Genauigkeit: Bewertung der Zuverlässigkeit von KI in der Anwendungssicherheit

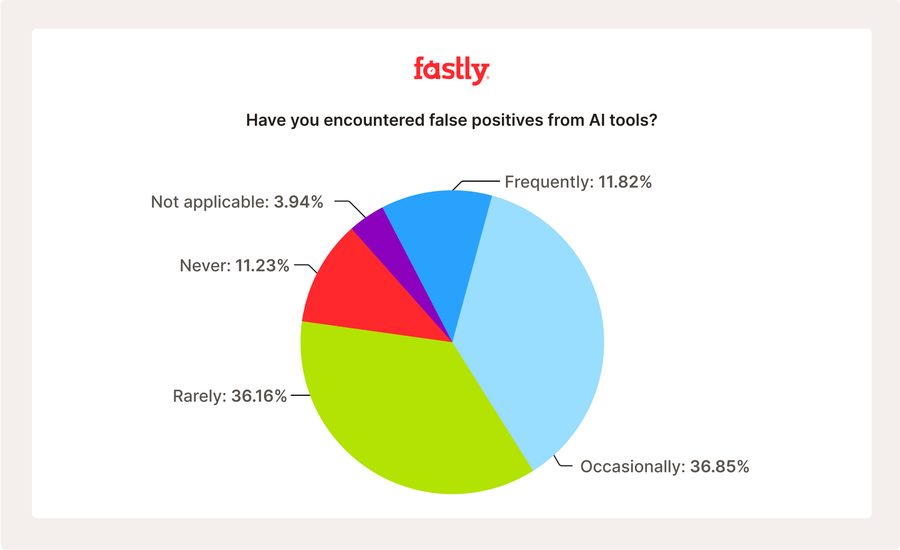

Angesichts der hohen Akzeptanz- und Integrationszahlen wollten wir die Meinungen der Befragten zur Zuverlässigkeit und Vertrauenswürdigkeit von KI besser verstehen. Wir fragten die Befragten nach der Häufigkeit von False Positives, die durch KI-gestützte Sicherheits-Tools verursacht werden. 37 % berichteten von gelegentlichen False Positives und 12 % von häufigen False Positives, sodass insgesamt fast die Hälfte (49 %) der Befragten zumindest gelegentlich False Positive feststellt – ein Ergebnis, das erhebliche negative Auswirkungen auf jedes Sicherheitsprogramm haben könnte. Nur 11 % gaben an, dass sie „niemals“ False Positives sehen. Dies wirft die Frage auf, ob KI-gesteuerte Sicherheitstools tatsächlich „ausreichend gute“ Sicherheitsergebnisse liefern.

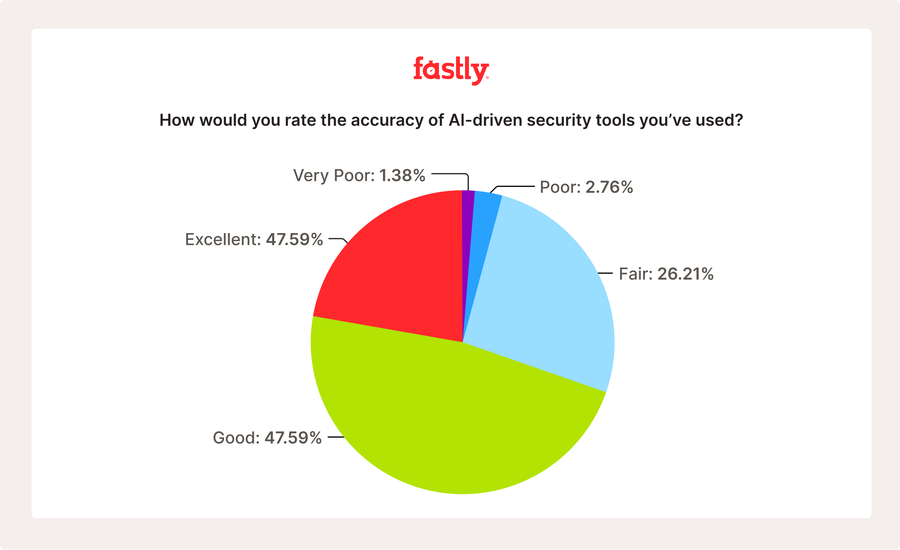

Wir haben weiter nachgeforscht und das allgemeine Vertrauen in die Genauigkeit von KI hinterfragt. Nur 22 % bewerteten sie als „ausgezeichnet“, während 48 % angaben, sie sei „gut genug“, und insgesamt 30 % sie entweder als „befriedigend“ oder sogar als „sehr schlecht“ einstuften. Wir wollten genauer untersuchen, mit welchen Herausforderungen Sicherheitsteams bei der Verwendung von KI in ihren Sicherheits-Workflows konfrontiert sind. Mit der Möglichkeit, mehrere Antworten auszuwählen, gaben die Befragten an, dass „die Komplexität der Integration“ (46 %), mangelndes Vertrauen in die Ergebnisse (36 %), unzureichende Erläuterungen zu Sicherheitsbefunden (23 %), interne Fertigkeitslücken (38 %) sowie regulatorische oder Compliance-Bedenken (33 %) die Sicherheitsteams beunruhigen.

In ihren Freitext-Antworten gaben die Befragten an, dass sie „im Nachhinein zu viel Debugging betreiben müssen“ und dass sie „ethische und Compliance-Bedenken“ hinsichtlich der KI-Nutzung in ihren Sicherheits-Workflows haben.

Die kritische Lücke: Auf AppSec-Probleme wird ohne menschliche Überprüfung reagiert

Bei der Betrachtung der Zahlen zur Akzeptanz/Integration im Zusammenhang mit den Antworten der Befragten zu KI-Aufsicht, Vertrauen und Ergebnissen lässt sich ein klarer Trend erkennen: KI ist integriert, sie trägt zur Beschleunigung der Prozesse bei und hilft, Lücken bei fehlenden Ressourcen und Fähigkeiten zu schließen – aber sie ist sicherlich nicht perfekt. Angesichts der vielen False Positives und der unterschiedlichen Einschätzungen hinsichtlich der Vertrauenswürdigkeit und der allgemeinen Genauigkeit wollten wir verstehen, welche Kontrollmechanismen Organisationen gegebenenfalls eingerichtet haben, um die Sicherheitsergebnisse zu überprüfen.

Wir fragten die Befragten, welcher Prozentsatz der mit KI-gestützten Sicherheits-Tools gefundenen Fehler dann ohne menschliche Überprüfung bearbeitet wird. 4 % der Befragten gaben an, dass zwischen 76 % und 100 % der identifizierten Fehler ohne menschliches Eingreifen bearbeitet werden. 26 % der Befragten gaben an, dass 51 % bis 75 % der identifizierten Fehler ohne menschliches Eingreifen behoben werden. Und weitere 26 % der Befragten gaben an, dass zwischen 1 % und 25 % der erkannten Fehler ohne menschliches Eingreifen behoben werden.

Das heißt , ein Drittel der Befragten gibt an, dass 50 % oder mehr der von KI-gestützten Tools in ihren Arbeitsabläufen identifizierten AppSec-Probleme ohne jegliche menschliche Überprüfung behoben werden. Angesichts der oben geäußerten gemischten Meinungen zur allgemeinen Genauigkeit und Leistungsfähigkeit von KI kann man mit Sicherheit annehmen, dass der Mangel an Aufsicht hier auf eine Mischung aus begrenzten Ressourcen und Bandbreite sowie einer ausreichend hohen Risikotoleranz zurückzuführen ist, um zu akzeptieren, dass KI „gut genug“ ist.

Diejenigen Unternehmen, die ein gewisses Maß an KI-Überwachung praktizieren, haben wir gefragt, welche Governance-Kontrollen sie eingerichtet haben, um die Ergebnisse zu überprüfen. 66 % der Befragten, die mehr als eine Antwort auswählen konnten, berichteten über Kontrollpunkte für die Überprüfung, 49 % über die Überprüfung von KI-Modellen, 46 % über Auditing und Logging und 32 % über sicheres Sandboxing. Während es vielversprechend ist, ein gewisses Maß an Aufsicht zu sehen, sollten diese Werte erneut zusammen mit den obigen Antworten betrachtet werden: Während es einige anständige Aufsichtspraktiken gibt, ist der Prozentsatz der Befragten, die sie anwenden, besorgniserregend gering.

Die Zukunft der KI in AppSec: Potenzial für mehr (bessere) KI

Mit Blick auf die Zukunft wollten wir von den Befragten wissen, was sie sich von KI in AppSec-basierten Anwendungsfällen erhoffen oder was sie brauchen. Als Antwort auf die Frage, welche Verbesserungen oder Fähigkeiten sich die Befragten von der KI im Bereich AppSec wünschen, gaben 32 % an, dass sie sich nicht sicher sind oder dass die KI im Moment gute Arbeit leistet. 18 % wünschen sich eine höhere Genauigkeit mit weniger False Positives, 10 % berichten von einem allgemeinen Bedarf an besseren AppSec-spezifischen Funktionen, und insgesamt 9 % wünschen sich schnellere Ergebnisse mit automatisierter Echtzeit-Schwachstellenerkennung während der Codierung.

Zu den wichtigsten Punkten dieser offenen Frage gehörte, dass sich ein Befragter „eine transparentere KI [wünscht], die Bedrohungserkennung sofort und mit höherer Genauigkeit kommuniziert“. Ein anderer „[wünschte sich], dass KI-Tools komplizierte geschäftliche Zusammenhänge besser verstehen, damit sie Schwachstellen besser priorisieren können.“ Und ein anderer erklärte, dass „KI die Fähigkeit haben muss, genau zwischen legitimen und bösartigen Aktivitäten zu unterscheiden und gleichzeitig die Gründe für ihre Entscheidungen zu erklären“.

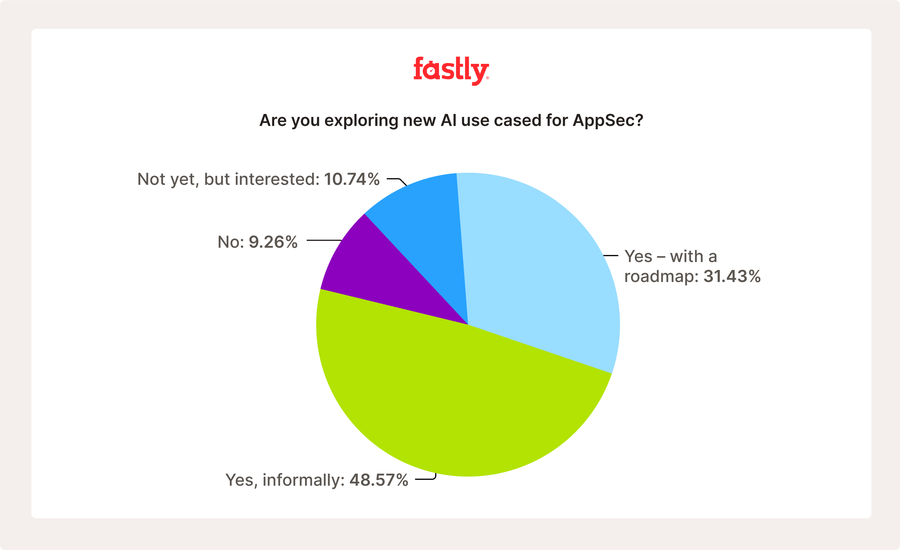

Wir haben die Befragten gefragt, ob sie neue oder zukünftige Anwendungsfälle für KI in ihren AppSec-Programmen untersuchen. 49 % gaben an, dass sie dies tun, wenn auch informell. 31 % gaben an, dies zu tun und eine formale Roadmap dafür zu haben. Insgesamt 20 % befassen sich damit entweder noch nicht oder haben Interesse daran, dies bald zu tun. Das bedeutet, dass insgesamt 80 % neue oder zusätzliche Anwendungsfälle für KI in der Zukunft erforschen. Die Befragten berichteten, dass sie „KI-gesteuerte Bedrohungsmodellierung und automatisierte Codeüberprüfung ausprobieren wollen, um die Sicherheit genauer und effizienter zu machen, und dass sie automatisierte Abhilfemaßnahmen, prädiktive Modellierung und KI-Codeüberprüfung durchführen [wollen]“.

Umfragemethodik

Diese Umfrage wurde von Fastly vom 20. August bis 3. September 2025 mit 1.015 Fachleuten durchgeführt. Alle Befragten bestätigten, dass sie im Rahmen ihrer Aufgaben für die Beeinflussung oder das Treffen von Entscheidungen über den Kauf und die Strategie der Anwendungssicherheit verantwortlich sind. Die Umfrage wurde in Nordamerika, Südamerika, Europa, dem Nahen Osten und Asien durchgeführt. Die Ergebnisse wurden einer Qualitätskontrolle unterzogen, um ihre Genauigkeit zu gewährleisten, obwohl, wie bei allen selbstberichteten Daten, eine gewisse Verzerrung möglich ist.