«Las soluciones de IA ofrecen la oportunidad de reducir gran parte del trabajo manual en materia de seguridad de las aplicaciones, gestión de vulnerabilidades y operaciones de seguridad. A pesar de los avances en la automatización de los flujos de trabajo, los equipos de seguridad siguen desbordados por la cantidad de trabajo que deben gestionar. La encuesta muestra que los responsables de la seguridad están aprovechando esta nueva tecnología para adelantarse a este problema y detectar y remediar rápidamente los riesgos de seguridad. Ahora, el reto será reducir la tasa de falsos positivos de las señales de seguridad generadas por la IA e integrar eficazmente estas soluciones en los flujos de trabajo, para que no queden en desuso». - Marshall Irwin, CISO, Fastly

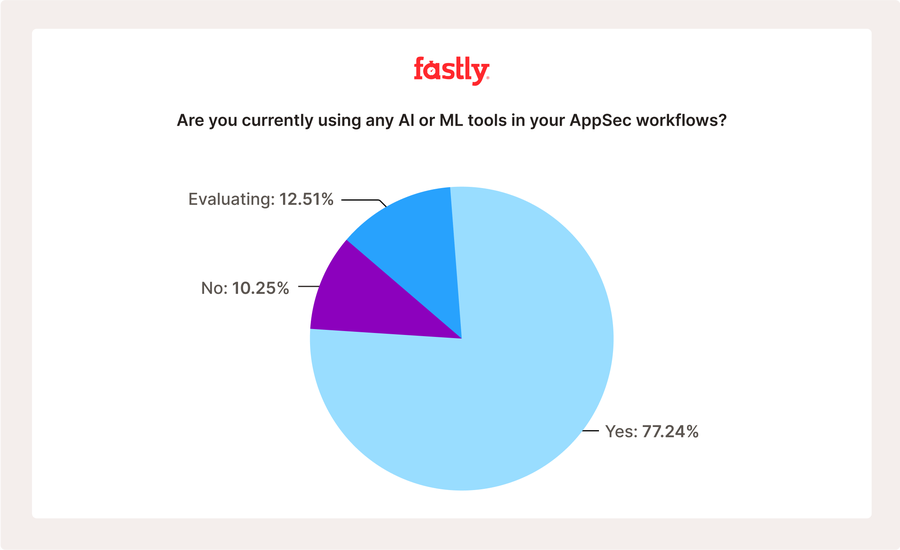

La rápida integración de la inteligencia artificial (IA) en la seguridad de las aplicaciones (AppSec) ha sido elogiada como un cambio revolucionario que promete aliviar la carga de trabajo manual y acelerar la detección de vulnerabilidades. Con la expansión de las superficies de ataque, los recursos limitados y la presión para enviar más código de forma rápida (pero segura), planteamos la hipótesis de que la IA podría ayudar a paliar esta situación. De hecho, nuestra última encuesta revela una tendencia sorprendente: el 90 % de los encuestados ya está utilizando o considerando activamente la IA en sus programas de seguridad de aplicaciones; el 77 % ya la está utilizando y el 13 % la está evaluando, al menos en cierta medida, dentro de sus programas y flujos de trabajo.

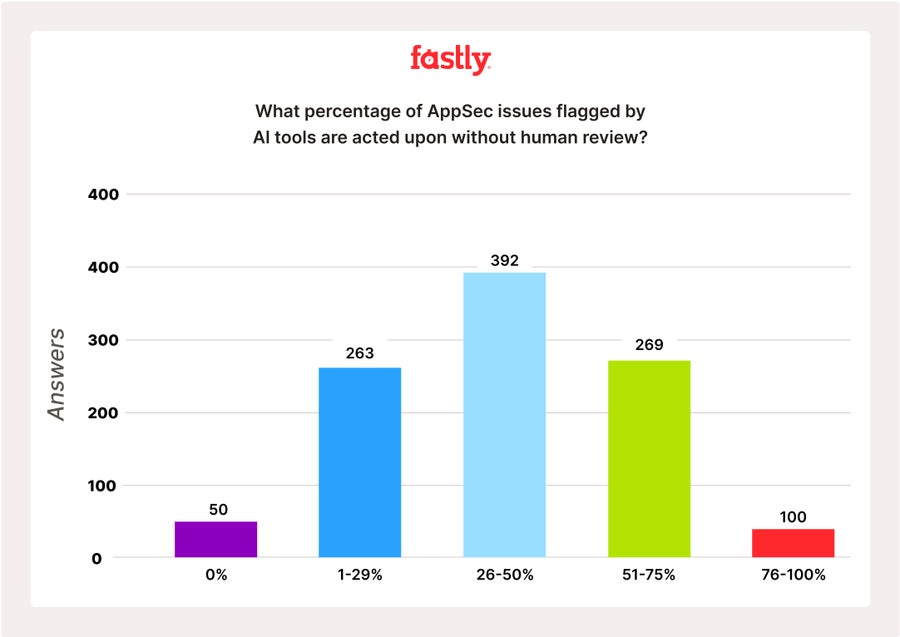

Sin embargo, bajo esta adopción entusiasta se esconde una paradoja crítica y quizás preocupante: a pesar de esta gran dependencia de la IA, los encuestados afirman que apenas supervisan los resultados. Un tercio de los encuestados afirmó que el 50 % o más de los problemas de seguridad de las aplicaciones identificados por las herramientas de IA en sus flujos de trabajo se resuelven sin revisión humana. ¿Se trata de un indicador de confianza o es una muestra de que los equipos asumen riesgos calculados para mantener el ritmo?

Tendencias en la adopción de la IA: un análisis profundo a nivel global e industrial

El 77 % de los encuestados afirmó que ya utilizaba la IA en sus flujos de trabajo de seguridad de aplicaciones, siendo el sector de la alta tecnología el que más la utilizaba (el 88 % la utilizaba en casos de uso de seguridad de aplicaciones). Le seguían de cerca el sector del software como servicio (SaaS) (86 %) y el sector sanitario (82 %), mientras que los sectores de los medios de comunicación y el entretenimiento (73 %) y el sector público (64 %) se quedaban ligeramente rezagados en la adopción de la IA. Sudamérica registró la mayor dependencia de la IA, con un 90 %, seguida de Asia (82 %) y Europa (80 %). Norteamérica se quedó un poco atrás, con un 75 %. Esto parece indicar posibles diferencias en cuanto a recursos o talento, ya que Norteamérica depende menos de la IA. ¿Quizás debido a la saturación de la oferta de talento en materia de seguridad y tecnología?

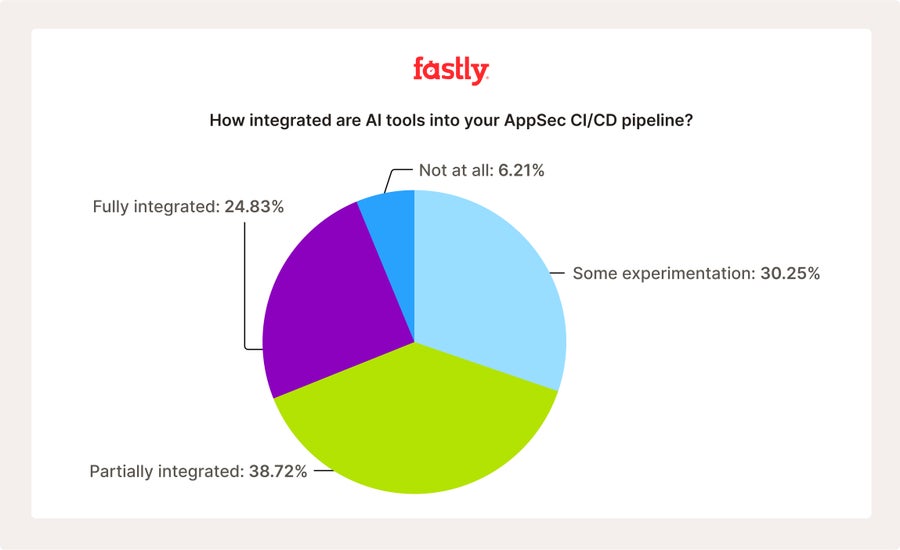

Al preguntarles sobre la integración en los procesos de CI/CD existentes y el uso de herramientas de seguridad basadas en IA, el 25 % de los encuestados respondió que la IA está totalmente integrada en sus canales de desarrollo actuales. El 39 % respondió que está parcialmente integrada; el 31 %, que están «experimentando» con su implementación; y solo el 6 %, que «no está integrada en absoluto» en los flujos de trabajo actuales. Las tendencias regionales observadas en la pregunta anterior se repitieron aquí: el 38 % de los encuestados sudamericanos afirmó que la IA estaba totalmente integrada en sus procesos existentes, mientras que en Norteamérica este porcentaje era solo del 25 %. Por sectores, el de la alta tecnología registró la integración más completa (40 %), en comparación con otros sectores como el de medios, entretenimiento y juegos, que registraron porcentajes más bajos: 19 % y 15 %, respectivamente.

Las ventajas de la IA para los encuestados son evidentes: el 55 % afirma haber reducido el esfuerzo manual, el 50 % detecta vulnerabilidades más rápidamente, el 36 % ha acortado los plazos de corrección y el 43 % destaca una mejora en las capacidades de clasificación. Sin embargo, ¿se consiguen estas ventajas a expensas de la precisión y la seguridad reales.

Confianza y precisión: Evaluando la fiabilidad de la IA en AppSec

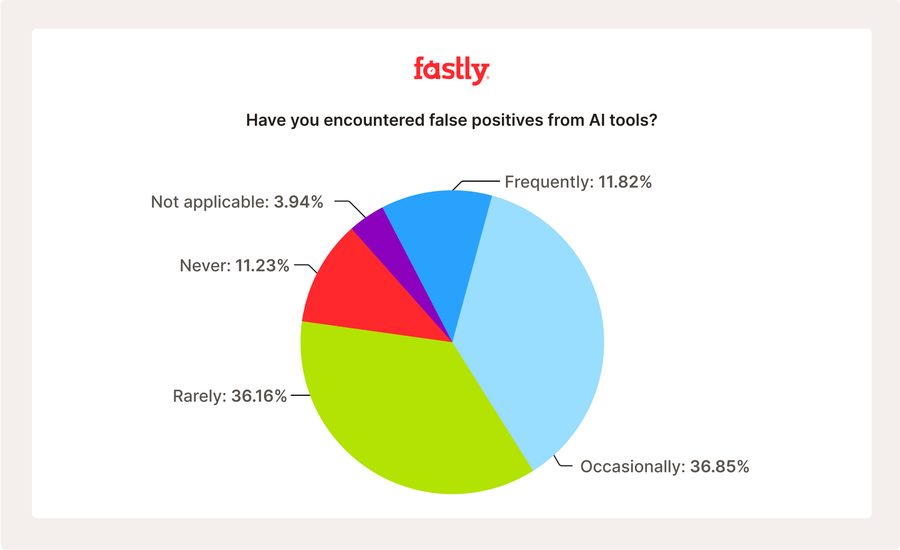

A la luz de las altas cifras de adopción e integración, quisimos entender mejor los sentimientos de los encuestados en torno a la fiabilidad y confianza en la IA. Preguntamos a los encuestados sobre la prevalencia de falsos positivos derivados de las herramientas de seguridad basadas en IA. El 37 % informó de falsos positivos ocasionales y el 12 % informó de falsos positivos frecuentes, para un total de casi la mitad (49 %) de los encuestados que ven resultados falsos positivos al menos algo frecuentes, un hallazgo que podría tener impactos negativos significativos para cualquier programa de seguridad. Solo el 11 % declaró que «nunca» ve falsos positivos. Esto plantea la pregunta de si las herramientas de seguridad impulsadas por IA realmente están produciendo resultados de seguridad «suficientemente buenos».

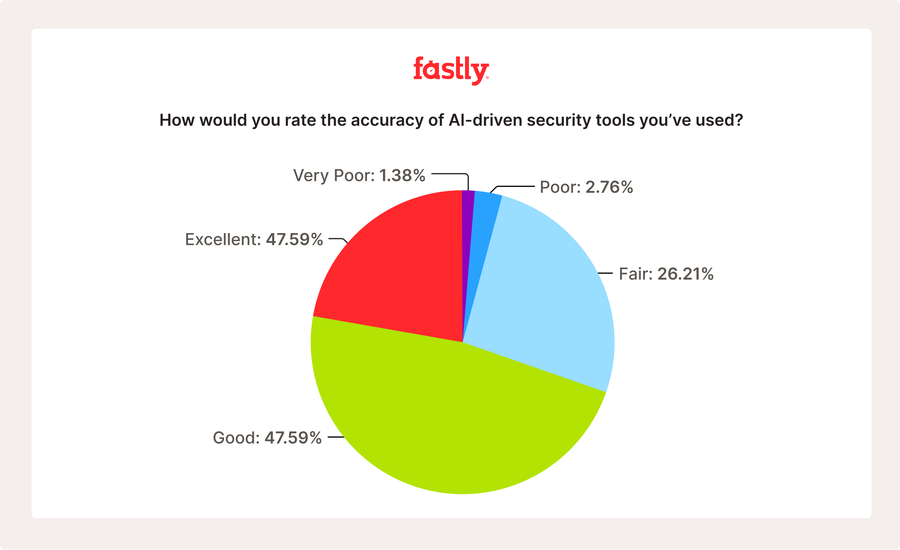

Profundizamos aún más cuestionando la confianza general en la precisión de la IA. Solo el 22 % la calificó como «excelente», el 48 % la consideró «suficientemente buena» y el 30 % restante la consideró regular o incluso «muy mala». Nuestro objetivo era explorar más a fondo los retos a los que se enfrentan los equipos de seguridad al utilizar la IA en sus flujos de trabajo. Los encuestados, que podían seleccionar varias respuestas, indicaron que la «complejidad de la integración» (46 %), la falta de confianza en los resultados (36 %), la dificultad para explicar los hallazgos de seguridad (23 %), las deficiencias internas en materia de competencias (38 %) y las preocupaciones relacionadas con la normativa o el cumplimiento (33 %) hacen que los equipos de seguridad lo piensen dos veces antes de utilizar la IA.

En las respuestas abiertas, los encuestados indicaron que «deben realizar demasiadas tareas de depuración posteriormente» y que «les preocupan cuestiones éticas y de cumplimiento normativo» en relación con el uso de la IA en sus flujos de trabajo de seguridad.

La brecha crítica: problemas de seguridad de las aplicaciones que no han sido revisados por humanos

Al analizar las cifras de adopción e integración junto con las respuestas de los encuestados sobre supervisión, confianza y resultados de la IA, se observa una clara tendencia: la IA está integrada, ayuda a acelerar los procesos y contribuye a paliar la escasez de recursos y habilidades, pero sin duda no es perfecta. Ante los falsos positivos y las opiniones divergentes sobre su fiabilidad y precisión generales, queríamos comprender qué medidas de protección, si las hay, han implementado las organizaciones para verificar los resultados de seguridad.

Preguntamos a los encuestados qué porcentaje de errores detectados mediante herramientas de seguridad basadas en IA se tratan después SIN revisión humana. El 4 % de los encuestados informaron de que se actúa sobre entre el 76 % y el 100 % de los errores identificados sin intervención humana. El 26 % de los encuestados informó que entre el 51 % y el 75 % de los errores identificados se corrigen sin intervención humana. Y otro 26 % de los encuestados informó de que entre el 1 % y el 25 % de los errores identificados se corrigen sin intervención humana.

Todo esto quiere decir que un tercio de los encuestados afirman que el 50 % o más de los problemas de AppSec identificados por las herramientas impulsadas por la IA en sus flujos de trabajo se solucionan sin ningún tipo de revisión humana.Dadas las opiniones contradictorias anteriormente expuestas sobre la precisión y el rendimiento generales de la IA, es lógico suponer que la falta de supervisión en este caso se debe a una combinación de recursos y ancho de banda limitados junto con una tolerancia al riesgo lo suficientemente alta como para aceptar que la IA es «suficientemente buena».

Para aquellas organizaciones que practican algún nivel de supervisión de IA, les preguntamos qué controles de gobernanza tienen implementados para verificar los resultados. Con la posibilidad de seleccionar más de una respuesta, el 66 % informó de que utiliza puntos de control de revisión, el 49 % utiliza la verificación de modelos de IA, el 46 % utiliza auditorías y registros, y el 32 % confía en entornos de pruebas seguros. Si bien es prometedor ver cierto nivel de supervisión, estos valores deberían volver a analizarse en conjunto con las respuestas anteriores: si bien existen algunas prácticas de supervisión decentes, el porcentaje de encuestados que las practican es preocupantemente limitado.

El futuro de la IA en AppSec: Potencial para más (y mejor) IA

Con la mirada puesta en el futuro, preguntamos a los encuestados qué esperan ver o necesitan ver de la IA en los casos de uso basados en AppSec. En respuesta a qué mejoras o capacidades desean ver los encuestados en la IA en Appsec, el 32 % respondió que no estaba seguro o que, por ahora, estaba funcionando bien. El 18 % desearía que fuera «más preciso y con menos falsos positivos», el 10 % señaló la necesidad de mejorar las capacidades específicas de AppSec en general y el 9 % restante desea obtener resultados más rápidos con la detección automatizada de vulnerabilidades en tiempo real durante la codificación.

Algunos de los aspectos más destacados de esta pregunta abierta incluyeron un encuestado que «[deseaba] que la IA fuera más transparente y comunicara las detecciones de amenazas inmediatas con mayor precisión». Otro «[deseaba] que las herramientas de IA pudieran comprender mejor el complejo contexto empresarial para poder priorizar mejor las vulnerabilidades». Y otro afirmó que «la IA necesita la capacidad de diferenciar con precisión entre actividades legítimas y maliciosas, al tiempo que explica los fundamentos de sus decisiones».

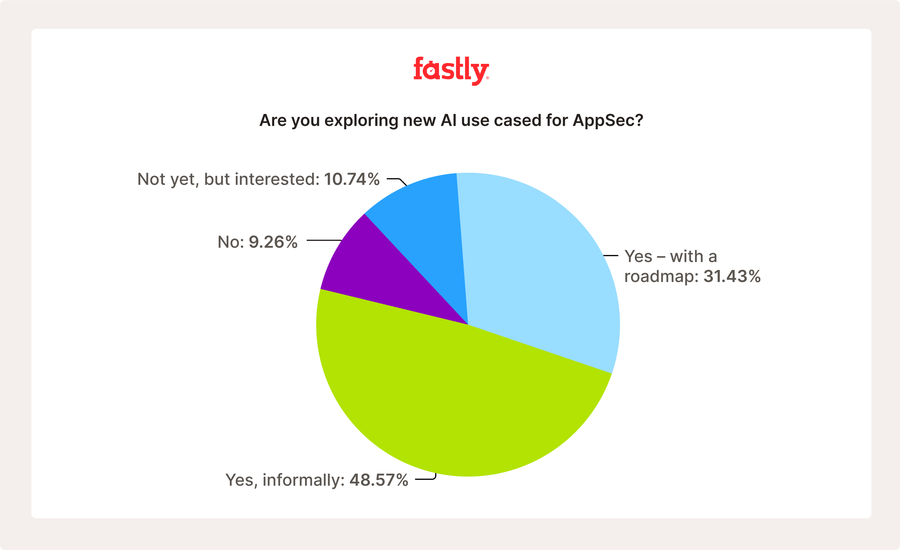

Preguntamos a los encuestados si están explorando casos de uso nuevos o futuros para la IA dentro de sus programas de AppSec. El 49 % informó que sí, aunque de manera informal. El 31 % informó que sí, con una hoja de ruta formal. Un total del 20 % aún no ha explorado o está interesado en hacerlo pronto. Esto significa que un 80 % combinado está explorando casos de uso nuevos o adicionales para la IA en el futuro. Los encuestados afirmaron "[querer] probar el modelado de amenazas basado en IA y la revisión automatizada de código para ayudar a que la seguridad sea más precisa y eficiente", y "[querer] hacer una reparación automatizada, modelado predictivo y revisión de código con IA".

Metodología de encuestas

Esta encuesta fue realizada por Fastly del 20 de agosto al 3 de septiembre de 2025, con 1015 profesionales. Todos los encuestados confirmaron que son responsables de influir o tomar decisiones estratégicas y de compra de seguridad de aplicaciones como parte de sus funciones. La encuesta se distribuyó en América del Norte, América del Sur, Europa, Medio Oriente y Asia. La calidad de los resultados se controló para determinar su exactitud, aunque, al igual que con todos los datos autoinformados, es posible que haya algún sesgo.